在人类文明的演进历程中,工具的创造始终是推动发展的关键力量。从远古时期粗糙的石器,到工业革命中轰鸣的蒸汽机,再到信息时代的计算机与互联网,这些工具作为人类能力的有力延伸,其行为模式向来是明确且可预测的。我们信任锤子,因为它必然会按照我们的意图砸向钉子,而绝无突然失控砸伤自己的风险。

但人工智能的横空出世,彻底颠覆了这一历经岁月考验的信任范式。AI 已不再是传统意义上简单被动的工具,正逐步蜕变成为我们并肩协作的 “队友”。在诸多关键领域,如自动驾驶汽车的辅助驾驶系统、医疗诊断环节、金融投资决策,甚至是战场上的生死较量,AI 的身影愈发频繁。这些 “队友” 具备强大的自主性、卓越的学习能力,甚至在某种程度上展现出自身独特的 “意图”。它们的决策并非基于简单直接的输入 – 输出逻辑,而是依托海量的数据资源、复杂精妙的算法模型以及基于概率的预测体系。

这一全新的变革,也带来了前所未有的信任困境。我们究竟该在多大程度上信赖一个存在犯错可能性,且决策过程宛如神秘 “黑箱” 的 AI 队友?或者,鉴于其潜在的风险,我们是否应选择对其敬而远之,哪怕因此错失技术革新带来的巨大福祉?答案显然并非简单的非此即彼。

以自动驾驶汽车为例,驾驶员若对其辅助驾驶系统过度信任,在系统突发故障时,可能因反应不及而无法及时接管车辆,从而引发车毁人亡的悲剧;反之,若对系统极度不信任,时刻神经紧绷,时刻准备接管车辆,那么自动驾驶的便捷与高效也就无从谈起。这正是当下人机协作所面临的核心矛盾之一。因此,重新审视并界定人与 AI 之间的信任关系迫在眉睫,而一种精确适配、动态调整且与 AI 实际能力紧密契合的 “校准信任” 理念,或将成为解决人机对齐问题的核心所在。

超越二元对立:校准信任的内涵

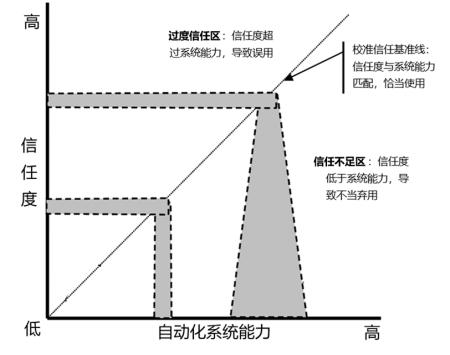

“校准信任” 这一概念源于人因工程学与认知心理学领域,其核心理念为:人类对于自动化系统的信任程度,应当与该系统在特定情境下的实际能力水平精准匹配,二者呈显著的正向关联。

当信任水平与自动化系统的实际能力出现偏差时,主要存在两种不良情形:

- 过度信任:一旦用户对 AI 的信任程度超越了其实际能力范畴,便极易引发对 AI 的 “滥用”。此时,用户往往会放松应有的警惕,减少甚至放弃必要的监督环节,更有甚者,会将 AI 系统应用于其设计能力范围之外的复杂任务。长期与高度可靠的自动化系统交互,用户很容易滋生过度依赖心理,一旦系统遭遇罕见但致命的故障,往往会导致灾难性的后果。

- 信任不足:当用户对 AI 系统的信任程度低于其实际能力时,“弃用” 现象便会随之出现。用户会频繁且不必要地干预或接管系统控制权,甚至直接拒绝使用该系统,使得 AI 系统的效能无法得到有效发挥。例如,一位经验丰富、医术精湛的外科医生,可能由于对 AI 辅助诊断系统的建议心存疑虑,从而错过更为优化的手术方案。

校准信任恰似在不信任到信任的光谱上,精准寻得的 “黄金分割点”。具备校准信任素养的用户,能够清晰洞察:

- 何时信任:在 AI 擅长的领域,如高速数据处理、精准模式识别以及重复性高强度劳动等方面,用户能够放心地将控制权交付给 AI,充分挖掘并发挥其优势。

- 何时不信任:当面临 AI 的能力短板或处于高风险决策情境时,比如遭遇未曾在训练中涉及的极端场景,或是需要进行复杂的伦理道德判断时,用户能够保持高度警惕,随时准备接管系统或进行必要的干预。

- 信任到何种程度:用户能够深刻理解 AI 决策结果的置信度。当 AI 给出高置信度的建议时,用户倾向于予以采纳;而当 AI 表现出决策的不确定性或犹豫时,用户会将其视为有待进一步验证的假设,而非直接执行的指令。

实现这种校准信任模式,能够促使人类从传统被动的系统操作者,转变为积极主动的监督者与决策者;同时,将 AI 从单纯被动的工具,提升为主动的信息提供者与任务执行者。人类得以成为 AI 能力边界的清晰定义者与合理使用者,AI 则成为人类意图的高效放大器。二者由此构建起一种优势互补、风险共担的和谐共生关系。

构建基石:提升双向透明度

若要实现更为精细、精准的信任校准,依据信任理论,“透明度” 是其中的关键密码。这里所提及的透明度,并非简单地公开大模型的源代码,或者提供一份冗长繁杂的 AI 技术手册,而是一种更为深层次、双向交互的沟通与理解模式,即 “双向透明度”。

这一创新模型涵盖两个相辅相成、不可或缺的维度:

- AI 代理对人的透明度:洞悉 AI 的世界观:此维度聚焦于人类对 AI 代理的深入了解,要求 AI 能够以人类易于理解的方式,清晰、全面地展示和阐释其 “世界观” 与决策逻辑,主要包含四个核心模型:

- 意图模型:旨在解答 “我为什么这么做?” 的疑问,AI 需要向人类清晰传达其最终目标与内在动机。例如,当自动驾驶汽车在紧急情况下采取避让操作时,它应能够明确告知用户:“我的首要目标是全力保障车内乘员的生命安全,其次才是遵循交通规则,因此我选择了压实线避让。” 如此一来,用户便能深刻理解 AI 的价值排序,进而准确预测其行为。

- 任务模型:着重解决 “我正在做什么,以及我打算怎么做?” 的问题,AI 需要向人类展示其对当前任务的精准理解、合理分解以及详细执行计划。这如同项目经理向团队成员展示详尽的项目甘特图,使每个人都能清晰把握项目进度、关键里程碑事件以及下一步行动方向。尤为重要的是,任务模型必须涵盖 AI 对自身能力的清醒认知,即 “我清楚自己能做什么,不能做什么”。例如,清洁机器人在工作过程中,若识别出地毯上的液体污渍超出了自身的清洁能力范围,应能够主动向人类发出求助信号。

- 分析模型:核心在于解释 “我是如何得出这个结论的?”,这是揭开 AI “黑箱” 的关键环节。AI 需要向人类提供其决策的坚实依据与完整推理过程。在此过程中,通常无需展示复杂晦涩的算法细节,而是借助可视化手段、生动形象的类比方式,或者突出关键特征等方法,让人类能够直观理解其结论的来源。比如,AI 医疗影像系统在标注病灶时,可以同步高亮显示其判断所依据的影像特征,如形状、密度、边缘等,并与历史病例进行相似度对比分析。

- 环境模型:主要回答 “我看到了什么,以及我认为环境如何?” 的问题,AI 需要与人类分享其对周围环境的精准感知与深刻理解。这不仅包括对其他智能体,如人、车以及其他 AI 代理的准确识别与行为预测,还涵盖对环境约束条件,如天气状况、路况信息、信号强度等的全面评估。通过这一模型,人类能够有效判断 AI 的感知是否全面、准确,是否存在潜在的 “感知盲点”。

当 AI 代理能够通过这四个模型向人类毫无保留地 “敞开心扉” 时,人类监督者在与其协作过程中,便不再如同面对一个神秘莫测的黑箱,而是与一个行为逻辑清晰、可理解的队友并肩作战。这种深度的透明度,无疑是构建校准信任的重要信息基石。

- AI 代理识人:让 AI “读懂人心”:在人与 AI 代理的协作关系中,若要真正实现高效协同,打造默契十足的团队,仅仅依靠人类对 AI 代理的了解是远远不够的,还需要 AI 代理展现出对人类处境的深刻洞察与理解。这无疑是人机协作领域中更具革命性与挑战性的一环。它要求 AI 代理不仅能够清晰地向外表达自身的意图与行为逻辑,更要具备敏锐的内部感知能力,深入理解其人类队友的实时状态、明确分工以及潜在意图。

- 理解人类状态:AI 需要借助先进的监测技术,全面感知并准确理解人类的认知状态、情感变化以及生理指标。通过眼动追踪、脑电波监测、心率变化分析、语音语调识别、面部表情捕捉等多模态传感器技术,AI 能够精准判断人类是否处于疲劳、压力过大、困惑不解、任务超负荷或高度专注等不同状态。如同一位贴心入微的队友,AI 能够在人类疲惫时主动承担更多任务,在人类困惑时及时提供详细清晰的解释说明。

- 理解社会分工:AI 需要将对人类状态与意图的理解,与当前具体任务情境紧密结合,准确判断人类的行为是否符合既定的任务分工要求。以驾驶任务为例,若 AI 检测到驾驶员在行车过程中分心看手机,而此时前方车辆正在紧急刹车,AI 能够迅速判断出 “驾驶员当前的行为与安全驾驶的任务分工需求严重不符”,进而及时发出强烈的警报信号,甚至在必要时主动采取干预措施,以确保行车安全。

- 理解人类意图:AI 需要具备强大的推断能力,能够精准推测人类的短期目标与潜在意图。这并非仅仅局限于简单执行人类的语音指令,而是要深入理解指令背后的深层次原因,达到一种心领神会的默契协作层次。例如,当用户对智能家居系统说 “我有点冷” 时,AI 不应仅仅机械地调高一度温度,而是可以综合结合时间、用户日常习惯以及当前室内温度等多方面因素,推断出用户可能即将准备休息,进而贴心地一并调暗灯光、播放舒缓的音乐,营造出舒适的休息氛围。

当 AI 代理能够成功 “读懂” 人类的心思与意图时,它便实现了从被动执行者到主动协作者的华丽转身。此时的 AI 能够提前预测人类的需求,灵活适应人类状态与行为的变化,甚至在人类出现决策失误或操作错误时,及时提供有效的兜底保障。这种深度的相互理解与信任,使得人机之间的信任关系不再是单向的 “我信任你”,而是升华成为双向的 “我们彼此充分信任,并且深刻理解对方”。这无疑代表了校准信任的最高境界与理想状态。

校准信任的构建路径与团队协作建议

若要在人 – AI 之间广泛、深入地建立起校准信任关系,离不开技术开发者与使用人 – AI 团队的共同不懈努力。针对这两个关键主体,我们提出以下具有针对性与可操作性的参考建议:

- 对技术开发者与设计师的建议:

- 将透明度作为核心设计原则:在系统架构设计的初始阶段,就应将 AI 代理的世界观四个模型,即意图模型、任务模型、分析模型和环境模型,深度融入其中。不能等到系统开发完成后,才事后诸葛亮般地考虑如何解释其行为与决策逻辑,而是要让 “可解释性” 与 “可感知性” 成为 AI 系统与生俱来的内在基因。

- 开发情境化的解释界面:要充分依据用户的不同角色定位、专业知识水平以及当前所处的具体任务场景,提供精准适配、恰到好处的解释说明,以实现高度的用户友好性。对于专业知识丰富的专家用户,可以提供更为深入、详细的分析模型细节,满足其对技术深度探究的需求;而对于普通大众用户,则应采用更加直观形象的类比方式与可视化手段,使其能够轻松理解 AI 的行为逻辑。同时,解释的时机选择也至关重要,应在用户最需要的时刻,比如系统即将做出关键决策之前,或系统表现出决策不确定性之时,主动、及时地向用户提供解释信息,而非被动等待用户查询。

- 构建鲁棒的人类状态感知模块:大力投资研发多模态生理与行为感知技术,并致力于开发能够准确解读这些复杂信号的先进算法模型。与此同时,必须将用户隐私保护与数据安全问题置于至高无上的优先级,确保所有涉及人类状态数据的收集、传输、存储与使用过程,都是透明、可控且严格符合伦理道德规范与法律法规要求的。

- 设计可协商与可调整的交互模式:坚决摒弃将 AI 的决策视为不容置疑的最终命令的传统观念。为用户提供清晰、便捷的交互接口,允许用户能够轻松自如地调整自动化等级,保留用户对 AI 建议的否决权,或者实现用户与 AI 共同制定任务计划的功能。这种赋予用户充分 “控制感” 的设计理念,是建立用户对 AI 信任的重要心理基础。

- 对人 – AI 管理团队的建议:

- 将人 – AI 团队训练制度化:训练无疑是建立校准信任最直接、最有效的方法之一。但这种训练不应仅仅局限于教授用户如何操作 AI 系统,而应将重点聚焦于如何促进人与 AI 之间的高效协作。具体的训练内容应涵盖以下几个关键方面:

- 理论学习:帮助用户深入理解 AI 的意图模型、任务模型、能力边界以及潜在的失效模式,使用户对 AI 的运行机制与行为逻辑有全面、深入的认知。

- 模拟演练:在安全可控的虚拟环境中,精心设计并让用户亲身经历各种正常、边缘甚至极端失效的场景,让用户在实践中学习如何准确解读 AI 发出的各类信号,掌握何时应当信任 AI、何时需要及时接管系统控制权,以及如何进行有效的干预操作。特别需要设计一些 “AI 不可靠” 的特殊情境,以帮助用户克服过度信任 AI 的潜在风险。

- 在岗培训与复盘:在实际任务执行结束后,组织人 – AI 团队进行全面、深入的复盘总结,共同讨论 AI 在任务中的表现、用户的决策过程以及二者之间的协作配合情况,通过持续的反思与总结,不断优化人 – AI 之间的协作策略与模式。

- 提升 AI 素养:在组织内部大力普及 AI 知识,确保每一位与 AI 协作的员工都具备基本的 AI 批判性思维能力。让员工深刻认识到,AI 固然是强大的生产力工具,但绝非无所不能的神器,其应用过程中同样伴随着不可忽视的风险。鼓励员工在与 AI 协作过程中,对 AI 的输出结果保持理性、客观的批判思维,并建立清晰、顺畅的渠道,方便员工及时报告 AI 出现的异常行为。

- 建立信任反馈闭环:积极鼓励用户详细记录并分享他们在与 AI 协作过程中的信任体验与感受。这些宝贵的反馈信息,对于技术开发者而言,是迭代优化 AI 系统的重要依据;对于管理者来说,则有助于调整完善团队的培训策略与管理方法。通过这种方式,能够形成一个 “设计 – 部署 – 反馈 – 优化” 的良性循环,持续推动人 – AI 协作关系的不断改进与完善。

无论我们是否已经做好充分准备,人 – AI 之间的关系正在经历一场深刻而全面的范式变革。人类正稳步迈向一个人与机器作为平等队友携手共进的崭新时代,这迫切需要我们与 AI 建立起深度的相互理解与精准校准的信任关系。我们必须积极拥抱校准信任所蕴含的智慧光芒,这不仅要求我们在技术层面全力实现 “双向透明度”,更需要我们在文化观念、教育培训以及制度建设等多个层面,为这种新型人机关系的蓬勃发展精心铺设道路。这无疑是一项艰巨复杂的系统工程,但只要我们齐心协力、持之以恒,必将迎来一个更加安全、高效、和谐的人机共生美好时代。

发表回复